Certains de mes lecteurs m'ont demandé d'inclure davantage d'informations sur la substitution sensorielle en général. Voici une série de textes sur la substitution sensorielle et sur la plasticité intermodale (voir aussi le log du 5 Janvier 2007).

Substitution sensorielle : Méthodes non-invasives

La substitution sensorielle non invasive cherche un intrant sensoriel autre que la vision pour aller stimuler le cortex visuel. Certaines méthodes exploitent l'audition pour remplacer la vision, tandis que certaines méthodes exploitent le sens tactile.

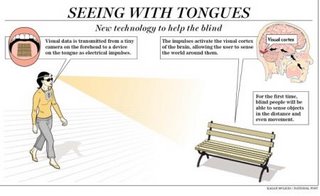

Depuis plus de quarante ans, Paul Bach-y-Rita travail à développer des systèmes de substitution sensorielle. La substitution sensorielle est la capacité de substituer un sens par un autre sens d’une façon fonctionnelle. Le remplacement de systèmes sensorielles perdus, principalement de la vue et de l’ouïe est un très vieux rêve. Le Braille par exemple, est une sorte de système de substitution sensorielle en soit. Dans l’exemple du Braille, on substitue la stimulation visuelle par une stimulation tactile. Dans la préface de son livre : Brain Mechanisms in Sensory Substitution (1972), Dr. Bach-y-Rita pose la question à savoir si les yeux sont essentiels à la vision, et les oreilles pour l’ouïe. Cette question peut sembler absurde, mais en réalité c’est exactement le problème que pose la substitution sensorielle. Est-ce que l’expérience de lire du braille peut être qualifié de vision? Ou est-ce plutôt une expérience tactile qui remplace la vision? Bach-y-Rita explique que les images captées par nos pupille ne quitte jamais notre rétine. De la rétine jusqu’au cerveau cet information voyage sous forme de pulsations électriques et chimiques et le cerveau l’interprète de façon visuelle. Nous ne voyons donc pas avec nos yeux, mais bien avec notre cerveau. La perception d’une image requiert beaucoup plus de la part du cerveau qu’une simple analyse de l’image. Cette perception se fonde sur la mémoire, sur l’apprentissage, sur une interprétation contextuelle, et beaucoup d’autres facteurs (Bach-y-Rita & Aiello, 1996). C’est cette constatation phénoménologique qui à sans doute donnée naissance à l’idée d’un système de substitution sensorielle qui remplace l’apport visuelle de l’œil par un apport visuel via la peau. Le Dr. Paul Bach-y-Rita invente en 1965 un appareil qui, muni d’une caméra vidéo, est capable de transmettre sur la peau sous forme de stimulation électrique l’image de la caméra. On peut reproduire certaines des qualités subjectives de la vision en utilisant des systèmes de substitution sensorielle (Kaczmarek, 1995), tels les illusions d’optiques, et une certaine forme d’apprentissage visuel. Ceci est un phénomène auquel j’ai pu assister dans mes propres expériences avec un appareil de substitution sensorielle électro-tactile. Une personne qui est aveugle de naissance n’a jamais eu l’expérience visuelle pour comprendre que quand un objet s’éloigne, il devient plus petit visuellement, et quand il s’approche il grossit. Ce sont des codes visuels que nous, les voyants, avons appris à force de voir ce phénomène. On peut assister à l’apprentissage tactile de ce phénomène en l’espace de quelques minutes lors de certains tests avec des sujets aveugles de naissance. Il est possible que l’expérience auditive de l’éloignement d’une cible, et la diminution des sons lointains puisse être transférée à l’expérience visuo-tactile, mais il demeure que cet apprentissage n’est pas immédiat, et requiert quelques minutes. Cet apprentissage, comme celui du lecteur de braille qui arrive, à force d’expérience, à faire des discriminations très fines avec ses doigts reflète la capacité du cerveau à se réadapter quand il survient une demande fonctionnelle (une nouvelle tâche), et un apprentissage qui comble cette demande fonctionnelle grâce à un intrant sensoriel. Cette réorganisation repose sur la plasticité du cerveau pour être fonctionnelle. C’est pour cette raison que l’on dit que la substitution sensorielle est la conséquence comportementale de la plasticité corticale. Le cerveau possède une étonnante capacité à se réorganiser selon l’expérience sensorielle qui lui est disponible. C’est grâce à cette capacité de réorganisation du cerveau (la plasticité) qu’un intrant tactile peut être interprété de façon visuelle par le cerveau. Par exemple la somatotopie des doigts est représentée sur le cortex visuel d’aveugles de naissance ayant appris à lire le braille (Kupers et al., 2006). Dans cet exemple les doigts remplacent l’œil pour la tâche de la lecture. Le cerveau s’adapte donc à gérer cet information du mieux qu’il peut avec l’espace corticale disponible. Puisque le cortex visuel est la partie du cerveau la mieux adaptée pour faire une tâche de lecture, et que l’absence de vision rend cette zone disponible pour traiter l’information tactile chez les aveugles de naissance, l’intrant tactile ira innerver le cortex visuel. Cela ne veut pas dire qu’un individu qui n’aura pas subi cette adaptation corticale ne pourra pas apprendre à lire le braille. Un voyant qui apprend à lire le braille ne subira peut-être pas de changements au niveau de son cortex visuel, et par conséquant il ne pourra jamais atteindre le niveau d’expertise de lecture du braille de certains aveugles de naissances capables de lire le braille à des vitesses supérieures de celles des voyants lisant un texte standard. La compétence supérieures de l’aveugle lisant du braille est rendue possible grâce au recrutement du cortex visuel pour cette tâche, tandis que le voyant est handicapé par l’absence de finesse de son cortex somatosensoriel pour accomplir cette tâche. Des études démontrent que des aveugles de naissance peuvent faire des discriminations de formes, d’orientation de lignes, de lettres de l’alphabet et du mouvement de cibles visuelles à l’aide de stimulation tactile sur la langue, et que cette stimulation active le cortex visuel de ces sujets (voir revue dans Ptito & Kupers 2005; Ptito, Moesgaard, Gjedde, & Kupers, 2005).

Écholocation et voir avec le son

En 1773, Diderot notait dans sa lettre sur les aveugles la capacité de certains non-voyants à s’orienter sans l’aide d’une canne, ils avaient un sens de la perception d’obstacles. Il précise que seulement certains aveugles le possèdent et que d’autres ne peuvent l’acquérir. Au début du siècle, on découvre que certains aveugles possèdent effectivement ce sens de perception d’obstacles,mais que la plupart d’entres eux en sont complètement incapables. À l’époque, deux hypothèses sur l’origine de ce phénomène étaient à la mode. La première hypothèse prétend que certains aveugles arrivent à ressentir des changements atmosphériques, tel le vent ou autres indice, sur la peau, et que ces indices leurs indiquent ou se trouvent les obstacles. On utilise le terme de vision faciale pour décrire ce sens des obstacles observés chez certains aveugles.

L’autre hypothèse observe que les aveugles utilisent les indices sonores pour percevoir les obstacles. Le terme d’écholocation humaine décrit la capacité de certains aveugles à se déplacer à l’aide de l’écoute des échos des sons qu’ils provoquent, par exemple, avec le tapement des pieds. C’est seulement en 1944 que les études de l’université Cornell (Supa et al., 1944) démontrent que des aveugles capables de détecter des obstacles n’étaient plus capables de le faire quand on leurs bouchait les oreilles. L’absence

de l’intrant tactile ne perturbait pas leurs sens des obstacles, mais quand on enlevait l’input auditif, ils n’en étaient plus capables. Cette hypothèse est confirmé par Worchel et Dallenbach (1947) qui démontrent que des sourds-aveugles ne peuvent pas percevoir des obstacles seulement avec le sens tactile. Les aveugles utilisent souvent cette technique en tapant leurs cannes sur le sol pour en entendre les échos. Kellogg (1962) fut le premier à réellement quantifier cette habilité. Il mesura la sensibilité de groupes d’aveugles et de voyants à la variations dans la taille, la distance et la texture d’objets perçus grâce à l’ouïe. Il démontra que les aveugles avaient des résultats nettement supérieurs aux voyants et que certains aveugles étaient sensibles non seulement à la distance et la taille d’un objet mais arrivaient même à distinguer les textures. Les sujets étaient assis face à différents disques de différentes tailles et textures et en utilisant des sons produit par le clappement des mains, à l’aide de la bouche ou des pieds écoutaient les échos pour faire un jugement de taille, de distance et de texture.

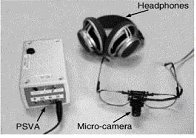

Avec l’invention des haut-parleurs les chercheurs pouvaient désormais utiliser des sons produit uniformément pour étudier l’écholocation humaine (Wilson, 1966). Ce sont ces études qui donnèrent naissance, beaucoup plus tard, aux systèmes de sonar qui remplacent la vue par l’audition (Bronkhorst & Houtgast, 1999; Kay, 2000). Ces systèmes utilisent l’information captée par une caméra et transmise à un ordinateur qui transforme les images en sons pour stimuler le cortex visuel (Renier et al., 2005).

On peut voir ici contre une schematisation du codage dune image en fonction du temps, de lamplitude et de la frequence du signal sonore. Le sujet peut donc apprendre a decoder une image sonore pour eventuellement se deplacer dans lespace, apprehender des objets, tel quillustre dans limage du vOICe dans spectrum.

Interface Tactile et voir avec la langue

Interface Tactile et voir avec la langue C’est avec beaucoup de tristesse que j’ai appris il n’y a pas longtemps le décès du professeur Dr. Paul Bach-Y-Rita. Ce grand chercheur fut un pionnier de la recherche en substitution sensorielle.

Le Dr. Paul Bach-Y-Rita développe en 1970 un appareil capable de transmettre l’information visuelle sur la surface cutanée du dos. Une caméra capte une image qui est transmise sur une grille électrotactile et les récepteurs cutanés acheminent l’information visuelle au cerveau qui traite l’information. Les études de cas nous montrent qu’il est possible avec un certain apprentissage d’utiliser cet appareil pour faire des jugements de distance et attraper des objets en mouvements. Plus tard, on adapte cet appareil pour la somesthésie de la langue plutôt que celle du dos. La raison du choix de la langue repose sur plusieurs critères. D’abord, la sensibilité de la langue est nettement supérieure à celle du dos. La surface corticale pour la langue est plus grande que celle dédiée à la somesthésie du dos.

Ce fait est illustré par l’homunculus, ci contre, qui indique la représentation relative des zones corticales allouées à chaque partie du corps.

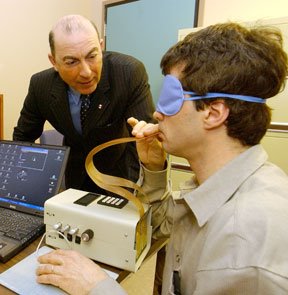

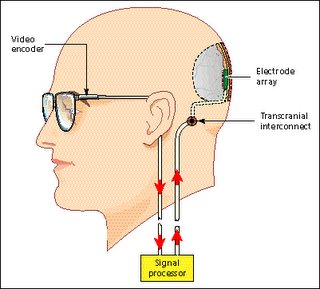

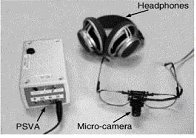

Le TDU se miniaturisa avec l’avènement de la micro technologie. La caméra est maintenant de la taille d’une « webcam, » et le transformateur est portable. Aussi, aujourd’hui nous avons la possibilité de démontrer à l’aide de techniques en imagerie les zones corticales sollicitées par la stimulation électrotactile de la langue pour la vision.

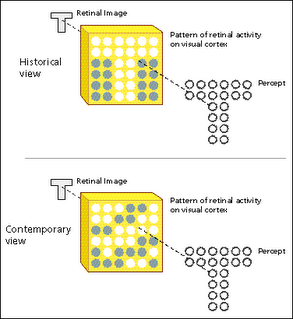

Cette activation du cortex visuel durant la lecture du braille est due à une réorganisation corticale suite à la privation sensorielle. En effet, certaines parties du cortex visuel sont recrutées par d’autres modalités chez les aveugles. La stimulation électrotactile de la langue sollicite aussi le cortex visuel chez les aveugles de naissance dans une tâche de discrimination (Ptito, Moesgaard, Gjedde, & Kupers, 2005). Il a été démontré dans cette étude que le cortex occipital prend en charge la fonction de discrimination tactile somatosensorielle sur la langue. La lettre T est projetée sur la langue sous forme d’influx électriques grâce à une grille de pixels placée sur la langue. Les aveugles ayant appris à discriminer l’orientation de la lettre T ont un taux de succès de 90% ou plus.

La stimulation magnétique transcrânienne (TMS) du cortex occipital chez les sujets voyants entraîne l’apparition de phosphènes visuels (Theoret, Halligan, Kobayashi, Merabet, & Pascual-Leone, 2004). La TMS chez les sujets aveugles ayant appris à utiliser le TDU entraîne l’apparition de sensations sur la langue, des phosphènes somatosensoriels. Cette même stimulation TMS n’entraîne pas de sensations sur la langue chez les sujets contrôles. Chez les sujets aveugles entraînés au TDU, la langue avait acquis une représentation cartographique dans le cortex occipital. Des sujets aveugles de naissance utilisent leur cortex visuel pour des tâches d’orientation tactile avec la langue (Ptito & Kupers, 2005).

Ces résultats suggèrent une réorganisation corticale suite à l’entraînement au TDU. Il existe aussi d’autres sortes d’interfaces tactiles avec le monde visuel. Par exemple il existe des cannes capables de transmettre l’information au-dessus de la tête du voyageur (une zone souvent dangereusement négligée par les utilisateurs de la canne).

La canne vient en deux modèle : un qui remplace l’image par un son, ou par une vibration de la canne, c’est au grès du voyageur.

La substitution sensorielle, la négociation d’obstacle et la navigation

L’évolution des systèmes de substitution sensorielle à été profondément marquée par une question en particulier : La substitution sensorielle peut elle aider à guider les aveugles dans la négociation d’obstacle et la navigation en général? La négociation d’obstacle chez les aveugles a été étudié sous plusieurs angles. Plusieurs études au début des années soixante exploraient la capacité des aveugles à détecter des objets à l’aide de sons (Kellogg, 1962). Les aveugles arrivaient à faire des discriminations de textures, de tailles, et de distances que les voyants n’arrivaient pas à faire à l’aide de sons. On se pencha ensuite sur le rôle de la longueur d’onde des sons, et du timbre (Wilson, 1966). Plus tard on démontra que bien que certains aveugles arrivent à se déplacer seulement à l’aide de l’écholocation, c'est-à-dire se diriger grâce aux sons « naturels » qui sont produit par les sujets, l’écholocation est une virtuosité qui n’est pas atteignable par toutes les personnes aveugles, mais bien un groupe très select d’individus plus doués que la moyenne. Aussi, l’écholocation n’est pas suffisante pour qu’une personne aveugle puisse se déplacer dans l’espace avec autant d’habilité qu’un voyant (Strelow & Brabyn, 1982). Par contre, cette habilité d’utiliser des sons pour localiser des obstacles ne requiert aucune expérience visuelle préalable (Ashmead, Hill, & Talor, 1989). Ces démonstrations inspirèrent l’invention du « sonic guide » (Kay, 2000). Cet appareil transforme les images captées par une caméra en ondes sonores que le sujet apprend à décoder pour se déplacer dans l’espace. La même idée est exploité par les systèmes du « tongue display unit » (TDU) et le « tactile vision substitution system » (TVSS) inventé par Bach-y-Rita à la même époque (Bach-y-Rita, 1967). Ces systèmes utilisent une caméra qui capte des image pouvant être transmise en temps réel sur une grille de pixels sous forme de stimulation électrique sur le corps

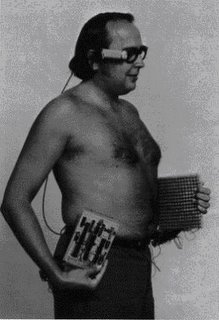

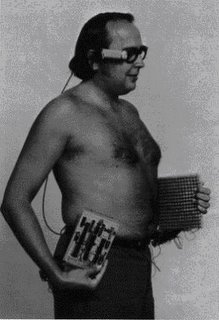

Un des premiers modèles du TVSS. La caméra montée sur les lunettes projette l’information à travers un circuit électrique (dans la main droite du sujet), pour être projeté sur une grille de vibrateurs portée sur la peau du sujet (dans la main gauche). Bach-y-Rita (1967) (TVSS) ou la langue (TDU). Une étude de cas décris les perceptions d’un sujet utilisant le TVSS pour identifier et localiser certains objets (Guarniero, 1974). Ces études, et les avancées technologiques permettent de croire qu’il serait possible pour un sujet aveugle de naissance d’apprendre à décoder l’information captée par ces appareils pour se déplacer et éviter des obstacles dans un environnement qui lui est inconnu. De la même façon qu’il y’a une sensibilisation des formes géométriques sous les doigts quand on apprend à lire le braille, le cerveau pourrait s’adapter pour différencier des changements d’intensités de courant sur la langue pour détecter des obstacles devant soi. Aucune étude avant mon projet de doctorat n’a étudié les capacités des aveugles de s’orienter dans un parcours à obstacle utilisant un appareil de substitution sensorielle. Le tout premier système TVSS qui substituait la vision par le touché (Bach-y-Rita 1965). Ce système était si immense qu’il était nécessaire d’utiliser une pièce complète pour l’accomoder. Les habilitées spatio-cognitives des aveugles sont semblables à celle des voyants quand on élimine l’avantage des voyants qui consiste à pouvoir percevoir des obstacles de beaucoup plus loin que les aveugles (Passinni et al., 1990). En effet, une personne aveugle ne peut percevoir que les obstacles qui sont à la porté de sa main, puisque c’est avec le sens du touché qu’il perçoit des obstacles, tandis que pour un voyant, les obstacles qui sont dans son champ de vision lui sont accessibles. On peut éliminer cet avantage, par exemple en plaçant les aveugles et les voyants dans un environnement contrôlé qui empêche les voyants de voir plus loin que la longueur de leur bras à cause de murs et de tournant qui empêche de voir plus loin que cette distance. Dans cette situation, les aveugles de naissance n’ont aucune déficience dans la conceptualisation d’un espace, et arrivent à se souvenir de trajets avec le même taux de réussite que les voyants (Passini et al., 1990). Les aveugles arrivent aussi à faire des jugements de distance avec le même taux de succès que les voyants, et ne sont déficients que dans l’évaluation de la direction (Byrne & Salter, 1983). Ces deux études suggèrent qu’avec l’aide d’un système de substitution sensorielle sophistiqué des aveugles de naissances pourrait se représenter un environnement et se déplacer en évitant des obstacles avec la même aise que des voyants. La substitution sensorielle repose sur l’extériorisation de la stimulation, ou la capacité de transférer la stimulation tactile de la peau à élément déclencheur dans l’environnement. Un voyant ne parle pas d’une sensation sur sa rétine quand il perçoit une image car il a appris que la stimulation de sa rétine par une image se réfère à un objet à l’extérieur de lui-même.

Dans le langage, on parlerait du signifiant, et du signifié. Le mot est le signifiant, et la signification du mot est le signifié. C’est la même chose pour une image, qu’elle soit tactile, ou visuelle. Il faut en quelque sorte « oublier » le signe pour se concentrer sur le signifié, le sens du mot. Un exemple de cette situation dans le cadre de la substitution sensorielle est une personne aveugle qui à appris à naviguer à l’aide d’une cane. La personne aveugle peut percevoir un obstacle, mais durant cette tâche perceptive, le sujet ne sera pas conscient du mouvement de sa main qui guide la cane, ou des sensations dans sa main. Il perçoit plutôt ces éléments comme des images mentales des objets dans l’espace. Le TDU tente d’exploiter cette spécialisation en permettant de « toucher » des objets qui ne sont pas dans l’environnement immédiat de l’individu (Bach-y-Rita, 1999). Le tout premier système de substitution sensorielle exploitait la sensibilité de la peau du dos pour transmettre l’information visuelle. À l’époque (1965) l’ordinateur était si gros qu’il fallait une pièce spéciale pour l’accommoder. La grille électro-tactile était montée sur une énorme chaise de dentiste. La caméra était difficilement amovible ce qui rendait la perception d’objet dans l’espace plus difficile. En effet, plusieurs études démontrent que pour que la sensation ressentie sur la peau soit interprétée comme provenant d’un objet dans l’espace il est nécessaire d’avoir le contrôle sur la caméra, sinon il est plus difficile de faire cette généralisation (Bach-y-Rita, 1972; Sampaio & Dufier, 1988). Fig. 3 : Une image d’un sujet navigant avec le dernier modèle du TDU dans un parcours à obstacle. Le TDU est porté sur la poitrine, relié à une caméra par un ordinateur de pocheLes premières expériences avec le TVSS n’arrivaient pas à faire identifier les objets par les sujets. Cet échec reflétaient la nécessité de pouvoir contrôler la caméra pour extérioriser la sensation sur la peau, et ne plus rapporter une sensation sur le dos, ou le ventre, mais bien à un endroit dans l’espace (White et al., 1970). Il semblerait donc que l’expérience visuel requiert la possibilité de pouvoir modifier l’impression sensorielle de façon contrôlé. Il est nécessaire que le sujet puisse modifier son point de vue par rapport à l’objet et que cette modification de l’emplacement du sujet se traduise par une modification perceptuelle liée au changement de perspective. Fig.4: l’homunculesLe dernier modèle du TDU est beaucoup plus petit, et avec l’avènement des micro-technologies il est très facilement portatif. L’usage de la langue à été préféré à celui de la peau du dos ou du ventre à cause de la surreprésentation corticale de la langue relativement aux autres parties du corps. Cette relation privilégié de la langue est illustré dans la figure 4 qui représente l’homuncules sensoriel. L’homuncules est la représentation à l’échelle de l’espace cortical réservé à chaque partie du corps. On voit une surreprésentation des

mains, des organes génitaux et de la langue, des lèvres (entre autres). C’est cette surreprésentation des doigts et de la langue qui est exploitée dans la substitution sensorielle. Cette surreprésentation est sans doute encore plus augmentée par la plasticité qui se produit suite à un entraînement au braille, ou au TDU. Bien que le TDU ne dispose que de très peu de pixels pour représenter une image visuelle complexe, et est nettement inférieure à la résolution de la vision, il est quand même possible d’accomplir certaines tâches perceptuelles complexes, tels la reconnaissance de visage, jugements de vitesses, directions de mouvements d’objets (Bach-y-Rita, 1967; Bach-y-Rita, 1999).

La résolution de la langue n’est donc pas une limite pour la perception visuelle. Les avenues de recherches ouvertes par le Dr. Bach-y-Rita sont très nombreuses. Les questions philosophique soulevées par ces constatations rejoignent certaines très vielles questions philosophiques sur la conscience. Par exemple, la question de Molyneux est d’actualité encore aujourd’hui puisqu’on se pose sensiblement les mêmes questions aujourd’hui. Il y’a plusieurs siècles déjà avec la naissance de la psychologie moderne on se demandait si une personne aveugle de naissance à qui ont rendait la vue pourrait transférer la connaissance qu’il possède déjà sur les formes géométriques d’un point de vue tactile à la vision qu’il vient de réacquérir. Aujourd’hui, on sait qu’une personne aveugle qui utilise le TDU sait reconnaître des formes géométriques qu’il connaît de façon tactile, mais on se pose la question à savoir si cette perception est vraiment de la vision. Dans la pré-histoire de la psychologie il y’avait une dichotomie entre la sensation et la perception. La sensation se référait à la stimulation d’un organe sensoriel qui envoyait un message vers le cerveau jusqu’a ce qu’un percept émerge. De cette façon, la représentation mentale d’une expérience (dans ce cas une image) n’est pas un produit direct de notre champ visuel, mais bien de l’esprit qui traite l’information (Schinazi, 2005). Dans cette optique le problème de la surcharge sensorielle semble imminent. Par exemple, la langue ne serait-elle pas débordée par la grande quantité d’informations qui lui est acheminée via la languette du TDU? En effet, comment croire que la peau puisse être aussi sensible que l’œil devant une scène visuelle? En fait nous savons aujourd’hui que le système perceptif d’organismes vivants est une machine remarquable de réduction d’informations. Par exemple, comment se fait il que dans un endroit bruyant nous arrivions à nous concentrer sur la voix d’un seul individu? C’est à cause de cet capacité que nous avons de réduire l’information pour que nous puissions l’utiliser. C’est pour cette raison que White et al., (1970) affirmaient que « les limitations de ce système sont causées par la pauvreté de l’affichage, et non pas par les limites des capacités de traitement d’information de la peau ».

Bien que cette affirmation demeure sans preuves concrètes, c’est ce que mon projet de recherche veut démontrer. Si les sujets de mon expérience arrivent à naviguer dans un parcours à obstacle complexe, c’est que l’information du TDU est suffisante pour se représenter un environnement de façon visuelle. Cette perception s’apparente donc davantage à une perception visuelle puisque l’information sur la peau est interprétée comme se référant à un objet dans l’espace, et non pas uniquement sur la surface de la peau. La cécité entraîne une diminution d’autonomie par un déficit d’orientation dans l’espace et de mobilité. Pour la plus grande majorité, l’incapacité des aveugles dans la navigation spatiale n’est pas due à un déficit de représentation de l’espace, puisque les aveugles, même ceux sans aucune expérience visuelle, arrivent à se représenter un environnement connu, et ont une bonne compréhension des grands espaces (Casey, 1978). Il n’est donc pas question de déficit au niveau de la représentation mentale d’un environnement puisque certains aveugles arrivent à créer des cartes cognitives de nouveaux environnements jusqu’alors inconnus, et ils arrivent même à acquérir certaines compétences spatio-cognitives en l’absence de vision ou d’expérience visuelle (Passini et al. 1990). Contrairement aux personnes souffrant de la maladie d’Alzheimer ayant de la difficulté à s’orienter dans l’espace à cause d’un déficit cognitif, les non-voyants ont une déficience perceptive. Cette perte d’autonomie est due à deux conséquences de la cécité: l’incapacité de voir des obstacles et l’inaccessibilité à l’information visuelle qui aide grandement à la formation de cartes cognitives d’un environnement.